|

|

|||

| personajes | ||||

|

Alfonso Nápoles Gándara

|

|

|||

|

Alberto Barajas

conoce más del autor

|

||||

| HTML ↓ | ← Regresar al índice ⁄ artículo siguiente → | |||

|

En 1930, el misterioso azar nos reunió a un joven profesor de matemáticas y a mí en un palacio. Ese año sería crucial en nuestras vidas, pero creo que ninguno de los dos lo presentía, aun cuando yo lo escuchaba atentamente disertar sobre las variaciones del trinomio de segundo grado.

La Universidad estaba estrenando la autonomía que conquistó en la lucha de 1929. En los mexicanos duraba todavía el estremecimiento provocado por las elecciones de 1928, en las que un general menospreció la Constitución y quiso reelegirse matando a sus dos contrincantes para asegurar su triunfo, aunque a su vez, después fue víctima, de una mano fanática instrumento de la justicia inmanente. El general Obregón murió exactamente el 17 de julio de 1928, día de mi cumpleaños.

Entré a la preparatoria lleno de expectativas, pues esperaba respuesta a muchas preguntas que me inquietaban: ¿en qué clase de país me había tocado nacer?, ¿qué sentido tiene la vida humana?, ¿qué cosa es la universidad y el amor y la cultura? Me obsesionaba, sobre todo, la pregunta que se han hecho los adolescentes de todos los tiempos: ¿qué rumbo le daré a mi vida?

Cada día estaba más desorientado y no podía dormir. Por otro lado juzgaba a mis profesores con frialdad implacable ya que me parecían menos interesantes que algunos, magníficos, que había tenido en la Secundaria 3. Pero existían dos excepciones: el joven Alfonso Nápoles Gándara y el viejo Erasmo Castellanos Quinto. Sí, con ellos las clases de matemáticas y de literatura universal eran muy gratas.

Como Kafka, fatigué desesperado los corredores del Palacio de San Ildefonso, y súbitamente empecé a escuchar voces que parecían venir de algún confín remoto para calmar mis dolores metafísicos. Una voz me dijo al oído: “No existen sino anhelos, Barajas. Lo demás no existe, Por los menos no existe vitalmente. La realidad de que habla la ciencia es realidad pensada; realidad viva sólo la tienen los objetos cuando en ellos se prende nuestro deseo o nuestra nostalgia. Tener las cosas no nos importa, importa aspirar a ellas o extrañarlas cuando ya se han ido. Parecemos los hombres una caravana que camina bajo el sol insoportable del desierto. Nos hacemos la ilusión de que somos mercaderes, pero lo que en verdad queremos es sentir sed. Sed de saber, sed de amar. Sed de gozar de sufrir; de vivir... de morir...”

Otra me dijo algo semejante con una metáfora: “Quiero doblar el arco de la vida hasta que forme un círculo. De mis manos saldrá entonces la flecha de la existencia que persigo. Correrá entre los bosques, saltará sobre un río... El aire, herido por su vuelo, irradiará: con luz de constelaciones que viene del infinito. ¿Podrá el arco doblarse, sin romperse, hasta formar un círculo? La flecha que saldrá de mi arco ¿llegará a su destino?” El mundo empezaba a aclarárseme.

El profesor Nápoles caminaba muy aprisa y con la mirada hacia adelante. Siempre iba muy derecho pues tenía una de esas espaldas sin curvatura que sólo se ven en el Colegio Militar. Fuera de clase parecía no reconocernos, en cambio, en clase... tampoco. Sus exposiciones eran muy claras, ya que calculaba muy bien las dosis de conocimiento que podíamos absorber sin mayor esfuerzo. Escribía en el pizarrón lo que era necesario y suficiente, y no nos abrumaba con dictados inútiles. Su voz era muy clara y se escuchaba perfectamente hasta la última fila.

Un día empezamos a notarlo nervioso y preocupado, entonces nos anunció que el curso tendría que acortarse y el examen final sería en agosto. Por los periódicos supimos la causa de su inquietud: le acababan de conceder la beca Guggenheim para hacer estudios superiores en el Instituto Tecnológico de Massachusetts. Era el primer matemático mexicano que obtenía tal honor. A partir de ese momento, nuestro respeto por él dio un salto cuántico.

Al darnos las calificaciones del examen comentó brevemente mi trabajo. Su demostración es interesante, me dijo. Tiene diez. Esa vez fue el único que puso.

Para Nápoles fue seguramente muy angustioso el contacto brusco con el mundo de la ciencia internacional. En aquella época había una gran distancia entre la preparación matemática que se podía obtener en México y la que ofrecían las grandes universidades extranjeras. Sólo el que ha estado en ellas puede apreciar el esfuerzo heroico de Alfonso Nápoles para acreditar catorce cursos semestrales de matemáticas superiores de categoría A con la máxima calificación de H, aprobado con honor, en once de ellos. Si consideramos que esto ocurrió en un lapso de año y medio, su actuación fue muy notable.

Regresó a México en 1932 con un tesoro de conocimientos que ha compartido con sus discípulos y sin los cuales no hubiera sido posible la colaboración con grandes científicos extranjeros. Cuando yo discutía con Einstein una teoría rival a la suya, la de Birkhoff, pensaba que esa conversación hubiera sido imposible sin el curso de Cálculo Tensorial que tomé con don Alfonso. Al pensar en su vida recuerdo inevitablemente las palabras que también escuché en 1930, mi año terrible, y que ya he mencionado en alguna otra ocasión: “Hay hombres que sólo entran al combate cuando el Rey está mirando. O son como Aristo, aquel filósofo tan elegante que sólo filosofaba cuando sus amigos lo llevaban en una litera lujosa. Hay otros, en cambio, que trabajan siempre que se necesita y en las condiciones menos favorables; dispuestos todo el tiempo a cumplir con sus deberes y sus ideales”.

La biografía de Nápoles nos muestra su devoción por las matemáticas y por la Universidad. Esta prodigiosa Universidad de México que tanto me deconcertó al principio y que al fin me reveló cuál era mi destino, mi dharma. Si en un momento de crisis no hubiera tenido un profesor de matemáticas tan distinguido, probablemente habría seguido otra carrera.

Alfonso Nápoles Gándara nació en Cuernavaca el 14 de octubre de 1897. Allí estudio la primaria; después estuvo en la Escuela Nacional Preparatoria y en la Escuela Nacional de Ingenieros, donde por su talento y originalidad llamó la atención del extraordinario Sotero Prieto.

Cuando Sotero murió, asumío el liderazgo del movimiento matemático en México. Más adelante, formó parte del grupo fundador de la actual Facultad de Ciencias, donde dirigió el Departamento de Matemáticas de 1939 a 1965. En 1942 se fundó el Instituto de Matemáticas, del que fue su primer director en noviembre de 1942, inició en Saltillo la serie de congresos de matemáticas que se han venido realizando con tanto éxito a lo largo de muchos años. Como consecuencia del primer congreso se creó la Sociedad Matemática Mexicana, la cual presidió hasta 1961. Desde entonces es Presidente Honorario Vitalicio.

Está casado con la señora Guadalupe Salazar y su hijo es el arquitecto Alfonso Nápoles Salazar, es hombre muy inteligente y muy creativo, quien además es distinguido y respetado en su profesión.

En fin, como quería el poeta, don Alfonso supo empuñar el arco con valentía y firmeza para lograr que la flecha llegara a su destino.

Septiembre de 1991

|

||||

|

Alberto Barajas

Instituto de Matemáticas,

Universidad Nacional Autónoma de México.

_______________________________________________________________ como citar este artículo → Barajas Celis, Alberto.(1999). Alfonso Nápoles Gándara. Ciencias 53, enero-marzo, 28-30. [En línea]

|

||||

|

|

||||

|

El diablo de los números

|

|

|

|

Hans Magnus Enzensberger

Ediciones Siruela, España, 1998

|

||

| HTML ↓ | ← Regresar al índice / artículo siguiente → | |

|

Hacía mucho que Robert estaba harto de soñar. Se decía: Siempre me toca hacer el papel de tonto.

Por ejemplo, en sueños le ocurría a menudo ser tragado por un pez gigantesco y desagradable, y cuando esta a punto de ocurrir llegaba a su nariz un olor terrible. O se deslizaba cada vez más hondo por un interminable tobogán. Ya podía gritar cuanto quisiera ¡Alto! o ¡Socorro!, bajaba más y más rápido, hasta despertar bañado en sudor.

A Robert le jugaban otra mala pasada cuando ansiaba mucho algo, por ejemplo una bici de carreras con por lo menos veintiocho marchas. Entonces soñaba que la bici, pintada en color lila metálico, estaba esperándole en el sótano. Era un sueño de increíble exactitud. Ahí estaba la bici, a la izquierda del botellero, y él sabía incluso la combinación del candado: 12345. ¡Recordarla era un juego de niños! En mitad de la noche Robert se despertaba, cogía medio dormido la llave de su estante, bajaba, en pijama y tambaleándose, los cuatro escalones y... ¿qué encontraba a la izquierda del botellero? Un ratón muerto. ¡Era una estafa! Un truco de lo más miserable.

Con el tiempo, Robert descubrió cómo defenderse de tales maldades. En cuanto le venía un mal sueño pensaba a toda prisa, sin despertar. Ahí está otra vez este viejo y nauseabundo pescado. Sé muy bien qué va a pasar ahora. Quiere engullirme. Pero está clarísimo que se trata de un pez soñado que, naturalmente, sólo puede tragarme en sueños, nada más. O pensaba: Ya vuelvo a escurrirme por el tobogán, no hay nada que hacer, no puedo parar de ningún modo, pero no estoy bajando de verdad.

Y en cuanto aparecía de nuevo la maravillosa bici de carreras, o un juego para ordenador que quería tener a toda costa —ahí estaba, bien visible, a su alcance, al lado del teléfono—, Robert sabía que otra vez era puro engaño. No volvió a prestar atención a la bici. Simplemente la dejaba allí. Pero, por mucha astucia que le echara, todo aquello seguía siendo bastante molesto, y por eso no había quien le hablara de sus sueños.

Hasta que un día apareció el diablo de los números.

Robert se alegró de no soñar esta vez con un pez hambriento, y de no deslizarse por un interminable tobogán desde una torre muy alta y muy vacilante. En su lugar, soñó con un pradera. Lo curioso es que la hierba era altísima, tan alta que a Robert le llegaba al hombro y a veces hasta la cabeza. Miró a su alrededor y vio, justo delante de él, a un señor bastante viejo, bastante bajito, más o menos como un saltamontes, que se mecía sobre la hoja de acedera y le miraba con ojos brillantes.

—¿Quién eres tú?— preguntó Robert.

El hombre le gritó, sorprendentemente alto:

—¡Soy el diablo de los números!

Pero Robert no estaba de humor para aguantarle nada a semejante enano.

—En primer lugar —dijo—, no hay ningún diablo de los números.

—¿Ah, no? ¿Entonces por qué estás hablando conmigo, si ni siquiera existo?

—Y en segundo lugar, odio todo lo que tiene que ver con las Matemáticas.

—¿Por qué?

—“Si dos panaderos hacen 444 trenzas en seis horas, ¿cuánto tiempo necesitarán cinco panaderos para hacer 88 trenzas?” Qué idiotez —siguió despotricando Robert—. Una forma idiota de matar el tiempo. Así que ¡esfúmate! ¡Largo!

El diablo de los números se bajó con un elegante salto de su hoja de acedera y se sentó al lado de Robert, que en protesta se había sentado entre la hierba, alta como un árbol.

—¿De dónde te has sacado esa historia de las trenzas? Seguro que del colegio.

—¡Y de dónde si no! —dijo Robert—. El señor Bockel, ese principiante que nos da Matemáticas, siempre tiene hambre, a pesar de estar tan gordo. Cuando cree que no le vemos porque estamos haciendo los deberes, saca una trenza de su maletín y se la devora mientras nosotros hacemos cuentas.

—¡Vaya! —exclamó el diablo de los números, sonriendo con sorna—. No quiero decir nada en contra de tu profesor, pero la verdad es que eso no tiene nada que ver con las Matemáticas. ¿Sabes una cosa? La mayoría de los verdaderos matemáticos no sabe hacer cuentas. Además, les da pena perder el tiempo haciéndolas, para eso están las calculadoras. ¿No tienes una?

—Sí, pero en el colegio no nos dejan usarla.

—Ajá —dijo el diablo de los números—. No importa. No hay nada que objetar a un poco de práctica con las tablas. Puede ser muy útil si uno se queda sin pilas. ¡Pero las Matemáticas, ratoncito, eso es muy diferente!

_______________________________________________________________

como citar este artículo → Magnus Enzensberger, Hans. (1999). El diablo de los números. Ciencias 53, enero-marzo, 68. [En línea] |

||

|

|

← Regresar al índice / artículo siguiente → | |

|

|

|||||

|

El lirio acuático, ¿una planta nativa

de México?

|

|

|||||

|

María Guadalupe Miranda A. y Antonio Lot Helgueras

conoce más del autor

|

||||||

| HTML ↓ | ← Regresar al índice ⁄ artículo siguiente → | |||||

|

El lirio acuático (Eichhornia crassipes) es una planta libre flotadora miembro de la familia de las Pontederiaceae, que ocupa un lugar sobresaliente entre las comunidades de hidrófitas de agua dulce de las regiones tropicales y subtropicales del mundo. Las flores que la conforman, por su forma y color, son tanto la estructura más vistosa de la planta como el principal motivo que ha favorecido su introducción en estanques y acuarios de todo el mundo. Los lóbulos de la flor presentan tonalidades que van del color morado al lila y al azul claro, destacando en el lóbulo superior central una mancha de color amarillo.

Su distribución en México es sumamente amplia, ya que crece en una gran diversidad de hábitats dulceacuícolas localizados desde el nivel del mar hasta los 2 250 metros de altitud. Los únicos lugares en los que no se ha registrado son los estados de Baja California Sur, Chihuahua, Zacatecas, Tlaxcala y Yucatán.

La abundancia y la frecuencia con la que encontramos el lirio acuático (Eichhornia crassipes) en los cuerpos de agua naturales y artificiales en México nos hace pensar que se trata de una planta nativa del país.

En las regiones fuera de su área natural de distribución, el lirio acuático es considerado maleza (planta indeseable) por la serie de problemas que acarrea su presencia y, sobre todo, por el crecimiento tan rápido de su población. En hábitats perturbados sustituye con frecuencia a elementos de la flora nativa. Tiene diversos efectos perjudiciales, entre los que se pueden mencionar el entorpecimiento de la navegación por ríos y lagunas, la elevación de los índices de evaporación y el impedimento del paso de la luz al fondo de los estanques, lo que trae como consecuencia la eliminación de microalgas que son el alimento de crustáceos y peces. Sabemos que el lirio acuático es una de las malezas, o planta invasora, más difíciles de exterminar en áreas inundables manejadas por el hombre en las regiones tropicales y subtropicales del mundo.

Según Orozco-Segovia y Vázquez-Yanes esta planta es considerada nativa de México y de Centroamérica, aunque existen dudas sobre las causas de su distribución fuera de las cuencas del Amazonas y del Orinoco, que corresponden al centro de origen y de distribución primaria, aunque estos autores también señalan que su presencia en México podría deberse a una introducción temprana.

En la búsqueda que realizamos en diversas fuentes botánicas antiguas del país hallamos algunos datos que parecen apuntar hacia la segunda suposición. En la Historia de las cosas de la Nueva España, obra escrita por Fray Bernardino de Sahagún, publicada cerca de 1590, se hace referencia a las plantas que existían en los lagos, pero no se incluye al lirio acuático. Igualmente, en la Historia natural de la Nueva España, publicada en 1576 por el naturalista Francisco Hernández, protomédico del rey Felipe II, se mencionan algunas plantas acuáticas, pero, una vez más, no al lirio acuático. En el Códice Badiano, escrito en 1552 reconocimos íconos de macrofitas acuáticas, pero el lirio acuático tampoco aparece.

Buscando las plantas útiles del México antiguo, Torres revisó en 1985 otras obras del siglo XVI, como las crónicas de José Acosta, Antonio de Ciudad Real, Fray Diego de Landa y Fray Alonso de Molina, en donde no se hace ninguna referencia al lirio acuático.

Algunos estudios palinológicos recientes que se han realizado en la zona central de México con objeto de encontrar registros de polen de lirio acuático en estratos correspondientes a épocas precolombinas no han tenido éxito. Todo esto nos hace pensar que el lirio acuático no formaba parte de la flora acuática de México en esa época.

En 1882, en el Calendario botánico del valle de México, Bárcena tampoco menciona al lirio acuático. El primer registro lo encontramos hasta 1903, en la obra de Manuel Urbina, después de la cual otros autores como Reiche, Ramírez-Cantú y Conzatti ya lo consideran parte de la flora acuática mexicana.

El origen

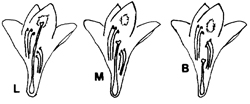

En el lirio acuático la morfología del órgano femenino de la flor o estilo varía en longitud y recibe los nombres de longistila (L), mesostila (M) y brevistila (B), respectivamente de mayor a menor talla (figura 1). A este fenómeno se le conoce como “heterostilia trimorfa” o “tristilia”.

Asumiendo que la mayor diversidad de formas de las especies se encuentra en la cercanía al centro de origen y de dispersión, y sin descartar la influencia del ambiente en la manifestación de la característica, podemos concluir que el lirio acuático es originario de la cuenca del Amazonas, en Brasil, ya que es únicamente allí donde se ha reportado la “tristilia”. También hay registros de “tristilia” en lagos cercanos a la confluencia de los ríos Paraguay y Paraná, en Argentina, en donde posiblemente se dispersó por medios naturales.

Las poblaciones de lirio acuático en Guyana, Venezuela y Colombia, así como en el Caribe, América Central y zonas templadas de América del Norte, parecen ser resultado de introducciones, ya que carecen del tamaño intermedio (la forma B). Esta idea se refuerza por la carencia de polinizadores especializados en América Central. El polinizador especializado registrado para el lirio es una abeja con lengua larga (Ancyloscelis gigas), que se ubica únicamente en la región amazónica donde se presenta la “tristilia”.

Resulta pertinente preguntarse si el lirio acuático pudo haber llegado a Centroamérica y a Norteamérica a través de mecanismos de distribución natural. Los órganos vegetativos de dispersión del lirio acuático incluyen las plantas completas u otras estructuras, como rizomas y estolones, y sólo pueden colonizar nuevos sitios que estén inundados. La dispersión es resultado del movimiento de los órganos vegetativos en los ríos, o bien, de las inundaciones que pueden acarrear los propágulos a lagos adyacentes, canales o diques.

Otro mecanismo de transporte de las semillas de algunas plantas acuáticas es el viento, pero las distancias alcanzadas son muy cortas. En el caso del lirio acuático, es poco probable que el viento las disperse, pues no tienen estructuras de transporte aéreo, como sucede con el tule ancho (Typha) y el carrizo (Phragmites).

Desde hace un siglo, Darwin explicó que la amplia distribución de ciertas especies vegetales de agua dulce se debía al acarreo de semillas y fragmentos vegetativos sobre el plumaje y las patas de las aves acuáticas. No obstante, para el caso del lirio acuático, que como ya mencionamos es una planta originaria de Brasil, es riesgoso considerar que este mecanismo como sea el responsable de las poblaciones del lirio asentados en Centro y Norteamérica, pues se carece de pruebas que indiquen su presencia desde el pasado.

Sin embargo, el hombre, de manera intencional, ha intervenido en la introducción y en la naturalización de nuevas plantas entre los hemisferios y entre los continentes. Sobre el lirio acuático, gracias a la magnífica obra compiladora de Gopal, se han documentado numerosos casos de introducciones a través de jardines botánicos instalados a partir de diversas exploraciones de naturalistas europeos en la región amazónica, en donde lo atractivo de su inflorescencia llamó considerablemente la atención.

Uno de los casos de introducción y naturalización del lirio acuático mejor conocidos sucedió en Norteamérica en 1884, con motivo de una exhibición de horticultura en la exposición de algodón en Nueva Orleans. Posteriormente, hacia 1894, en el delta del río Mississipi en Lousiana se registró el primer obstáculo serio para navegar en los ríos y corrientes que desembocaban en el golfo de México. Se considera que la naturalización del lirio acuático en esa región de Estados Unidos ocurrió durante la década de 1860 a 1870, y que hacia 1880 y, claramente después de 1900, el lirio acuático ya había invadido otras regiones como los Everglades en Florida. Más adelante, en 1903, el lirio se colectó por primera vez en Texas y, al año siguiente, ya se encontraba en California.

En Las chinampas del Distrito Federal, de Santamaría, se hace referencia a la introducción del lirio acuático a México: “entre las plantas acuáticas destaca el lirio acuático que es conocido desde hace solo catorce años, en que fue introducido por orden del general Carlos Pacheco, entonces secretario de Fomento”. De acuerdo con esta información, fue en 1898 cuando el lirio acuático llegó a los lagos del valle de México.

También debe considerarse la dispersión accidental, en particular de las semillas y de las fracciones vegetativas que crecen entre los cultivos irrigados y que se distribuyen con los productos cosechados y a través de embarcaciones, vehículos y maquinaria agrícola.

Su fácil dispersión

La dispersión del lirio y su establecimiento exitoso están directamente relacionados con las características ambientales abióticas y bióticas. A pesar de la amplia tolerancia a los factores abióticos del medio, y de ser una especie que puede llegar a invadir cuerpos de agua en regiones templadas y a altitudes considerables (su registro a mayor altitud en el mundo es en la ciudad de México), el lirio acuático no soporta las heladas y su crecimiento es limitado por la salinidad. En todo el mundo, su crecimiento óptimo se da a pH de 7 y adquiere el rango de infestación masiva entre 6.2 y 7.

En la variedad de hábitats de los sistemas fluviales del Amazonas y de los ecosistemas acuáticos de la región neotropical, en general, el lirio compite con otras especies de hidrófitas libres flotadoras (Azolla spp., Hydromistria stolo nífera, Pistia stratiotes, Lemna spp., Salvinia spp.) en mosaicos densos típicos de este tipo de comunidades naturales. Es interesante notar que el crecimiento masivo y con características de infestación de cualquiera de las especies mencionadas (especialmente Salvinia) en sus áreas naturales de distribución, sólo se ha registrado en donde artificialmente se cambió el régimen hidrológico, favoreciendo la formación de poblaciones dominadas por una sola especie.

La química del agua no limita el crecimiento del lirio acuático, pues su rango de tolerancia es amplio y el único factor que lo afecta es la carencia de fósforo. El lirio puede establecerse en aguas con pocos nutrientes, debido a las asociaciones microbianas que presenta en la rizosfera, y mientras más eutrófico sea el medio, más éxito tiene su propagación.

Entre las características de adaptación más importantes del lirio acuático están: a) su rápida capacidad de reproducción vegetativa; b) la habilidad para regenerarse a partir de pequeñas porciones del talo vegetativo; c) la completa o parcial independencia de la reproducción sexual; d) la morfología del crecimiento, que resulta en el desarrollo de la mayor área posible de tejido fotosintético, con relación al total de la planta y el cual rápidamente ocupa la superficie del agua, y e) independencia de las condiciones del sustrato y del nivel del agua.

Existen especies taxonómicamente cercanas, las cuales no son invasoras. Así, Eichhornia azurea es una especie estrechamente cercana a E. crassipes, con patrones de distribución nativa similar. Además, en contraste al hábito libre flotador de E. crassipes, E. azurea y las otras seis especies del género están unidas al sustrato. Es claro que la habilidad para llevar a cabo una propagación vegetativa rápida, unida al alto grado de movilidad, ha favorecido la dispersión de E. crassipes por encima de E. azurea.

Las fluctuaciones del nivel del agua inducen al lirio acuático a adoptar una forma emergente, con la elongación del pecíolo. Cuando la desecación es larga, los estolones quedan entrelazados esperando la época de inundación. A esta capacidad para modificar la forma y el tamaño de sus estructuras vegetativas cuando crecen bajo diferentes condiciones ambientales se le denomina plasticidad morfológica. Este atributo se ejemplifica bien en el lirio con la “heterofilia” o con la presencia en un solo individuo de dos o más tipos diferentes de hojas. La plasticidad morfológica y la habilidad para experimentar un crecimiento vegetativo rápido son los atributos clave que le dan a Eichhornia crassipes el éxito en la competencia interespecífica con otras plantas acuáticas invasoras.

Como en otras muchas macrofitas, en el lirio acuático hay una tendencia a reemplazar la reproducción sexual por la asexual. El ciclo completo de semilla a semilla es muy lento, ya que dura más de cinco meses. Además, para la germinación de la semilla es un requisito indispensable, la escarificación (rompimiento de la cubierta externa). En la propagación vegetativa el lirio produce estolones (tallos horizontales) que desarrollarán hojas arrosetadas de una yema terminal. Este proceso se repite en las plantas hijas y cuando se tienen las condiciones ideales, un número inmenso de plantas se pueden producir en corto tiempo, hasta duplicar la población en un periodo que va de cinco a quince días.

La presencia masiva e invasora del lirio ha llevado a buscar soluciones para su control. El hecho de que no existan herbívoros naturales, ni plagas que lo afecten, ha llevado a que actualmente se realicen estudios para utilizar hongos patógenos que puedan limitarlo. También se estudian diferentes artrópodos (coleópteros y lepidópteros) que puedan eliminarlo y se han probado, además, peces herbívoros como control biológico, entre los que podemos mencionar: Ctenopharyngodon idella, Tilapia rendalli y Metynnis roosevelti.

Una planta introducida

A través de los registros históricos, antropológicos y palinológicos, no se ha podido comprobar la existencia del lirio acuático en México en la época precolombina, por lo que se podría pensar que fue introducido voluntariamente como planta de ornato en Estados Unidos hacia 1884. Es posible que de ahí se haya dispersado en forma natural por medio de aves migratorias hasta llegar a nuestro país.

De cualquier forma, su introducción o naturalización en los lagos mexicanos no debió ocurrir antes de 1884. Lo que si es claro es su establecimiento y creciente poblamiento en nuevos espacios, desplazando a otras plantas acuáticas más sensibles a la perturbación humana.

La presencia del lirio acuático en ecosistemas lacustres estables con una alta biodiversidad es un fenómeno raro y su condición de planta “oportunista” sólo ocurre con la alteración del hábitat, especialmente cuando se presenta un incremento de nutrientes (eutroficación) por el derrame de fertilizantes o aguas negras. Desafortunadamente, hoy día es alarmante la modificación de los ambientes acuáticos naturales y el aumento de cuerpos de agua artificiales (presas, canales de irrigación, estanques de crecimiento, etcétera) que, por su inevitable conexión, pueden eventualmente contaminar grandes sistemas acuáticos a través de los ríos y de las crecientes durante los meses de lluvias y con la presencia de ciclones y otras perturbaciones meteorológicas. Con ello se favorece la invasión de Eichhornia crassipes como maleza a niveles que no pueden de controlar ni la naturaleza ni el hombre.

|

||||||

|

Referencias Bibliográficas

Gopal, B. 1987. Water Hyacinth. Aquatic Plant Studies. 1. Amsterdam, Elsevier Science Publishers, 471 p.

Mitchell, D. 1974. Aquatic vegetation and its use and control. Nueva York, unesco. pp. 38-49.

Orozco-Segovia, A. y C. Vázquez-Yáñez. 1993. Especies Invasoras: su impacto sobre las comunidades bióticas. México, Pronatura, A.C. pp. 29-31.

Sculthorpe, C. 1967. The biology of aquatic vascular plants. Londres, Edward Arnold. 610 p.

West, R. y P. Armillas. 1959. “Las chinampas de México, poesía, y realidad de los jardines flotantes”, en Cuadernos Americanos, 50, pp. 165-182.

|

||||||

|

María Guadalupe Miranda A.

UAM, Iztapalapa.

Antonio Lot Helgueras

Instituto de Biología,

Universidad Nacional Autónoma de México.

_______________________________________________________________ como citar este artículo → Miranda A., María Guadalupe y Lot Helgueras, Antonio. (1999). El lirio acuático, ¿una planta nativa de México? Ciencias 53, enero-marzo, 50-54. [En línea] |

||||||

|

|

||||||

El método de las ciencias

|

||

|

Rosaura Ruiz y Francisco J. Ayala

Fondo de Cultura Económica, México, 1998.

|

||

| HTML ↓ | ← Regresar al índice / artículo siguiente → | |

|

La ciencia se mueve, cambia de lugar, se agita. Es veleidosa y frágil. Por dentro y por fuera, se transforma. Está tan viva como un ejemplar de una especie, libre o en cautiverio, que muestra facetas desconocidas aun para los mismos que, en apariencia, la elaboran con absoluto control, y se les escapa, huye. Y luego se queda quieta, inmóvil, camuflada, a la espera, como si supiera que una infinidad de miradas la acechan, pendientes de ella, para aprehenderla. Los científicos saben todo esto y saben también que la certeza absoluta no es inherente al método científico, no es infalible; avanza cuando unos científicos refutan teorías de otros científicos, o de sí mismos al reconocer equivocaciones, y entonces aquél adquiere uno de sus rasgos más significativos, el lado humano, en el momento en que hace que la ciencia avance, socializada por vía del lenguaje. He aquí el tema central de esta obra de Ruiz y Ayala: a la ciencia se la puede estudiar y comprender de igual modo que como han procedido las epistemologías evolucionistas, sólo que en este caso no son los entes vivos la unidad de conocimiento, sino los conceptos y las teorías, en su origen, devenir y futuro, partiendo de la idea de que todo términos darwinistas, aunque por supuesto, en la aproximación de este problema es necesario adecuar el darwinismo a la teorización de carácter social, ya que los primeros darwinistas también pensaron que su paradigma era tan general que podía extenderse a toda entidad cambiante. Así, las maneras discrepantes en que varias teorías tratan de dar cuenta de determinado problema —específicamente el desarrollo de la ciencia, con sus controversias y polémicas— se analizan en estas páginas en las que el propósito más importante de los autores es estimular el interés en estas teorías, reconocer sus fundamentos, identificar lo que hay de válido en ellas y definir sus límites.

_______________________________________________________________

como citar este artículo → Ruiz Gutiérrez, Rosaura y Ayala, Francisco J. (1999). El método de las ciencias. Ciencias 53, enero-marzo, 69. [En línea]

|

||

|

|

← Regresar al índice / artículo siguiente → | |

Energía

|

||

|

Ana María Sánchez, María Trigueros y

Julia Tagüeña

Historias de la ciencia y la técnica,

UNAM, México, 1999.

|

||

| HTML ↓ | ← Regresar al índice | |

|

Energía... Cuántas veces hemos oído esta palabra. Aunque la usamos muy a menudo, ¿podríamos decir qué es?

La energía es un concepto complejo de definir pero muy útil. Lo utilizan casi todas las ciencias y es también parte de nuestro vocabulario cotidiano.

¿Hace cuánto tiempo que hablamos de energía? Estamos tan habituados a hacerlo que pensamos que el concepto es muy antiguo, pero no es así. Los antiguos griegos usaban la palabra “energía” para referirse a la eficacia, el poder o la virtud para obrar. Ni Galileo ni Newton, siglos después, conocían el concepto en la forma en que hoy lo manejamos. No fue sino hasta mediados del siglo xix cuando varios científicos que hacían experimentos diferentes en diversos lugares encontraron que fenómenos que hasta entonces se pensaban ajenos unos a otros, como el calor y el movimiento, la electricidad y el magnetismo, el movimiento y la luz, la afinidad química y el calor, y otros más, se relacionaban entre sí. Es más, estos fenómenos podían transformarse uno en el otro y en esa transformación podía definirse un concepto abstracto que da cuenta de algo que se conserva: la energía.

La energía es un concepto unificador en la naturaleza, y por su carácter abstracto es más fácil de definir en términos de sus manifestaciones.

La energía se manifiesta de muchas formas que pueden intercambiarse: mecánica, calorífica, eléctrica, química, magnética, nuclear. Las distintas formas de energía se transforman unas en otras, y lo más importante es que en ese proceso la cantidad total de energía se conserva. A este fenómeno se le llama principio de conservación de la energía.

El descubrimiento del principio de conservación de la energía representó un momento importante en la historia de las ciencias. Su nacimiento permitió descubrir que varias de ellas, que hasta ese momento se estudiaban por separado, constituían partes de un todo: la física. Desde su nacimiento este principio ha estado ligado íntimamente a la tecnología. Su aplicación permitió el desarrollo de nuevas industrias que cambiaron totalmente nuestra forma de vida.

El concepto de energía ha sido un motor del desarrollo de la ciencia y la tecnología. Su papel ha sido fundamental y sólo mediante un conocimiento profundo de este concepto y de sus consecuencias podremos comprender y manejar los efectos de la tecnología sobre el ambiente y la sociedad.

_______________________________________________________________

como citar este artículo → Sánchez, Ana María y Trigueros María, Tagüeña Julia. (1999). Energía. Ciencias 53, enero-marzo, 70. [En línea]

|

||

|

|

← Regresar al índice | |

|

|

|||

| del bestiario |

||||

| La biodiversidad en el Asteroide B 612 |

|

|||

|

Héctor T. Arita

conoce más del autor

|

||||

| HTML ↓ | ← Regresar al índice ⁄ artículo siguiente → | |||

|

Si existiera un programa de conservación de la biodiversidad a nivel del sistema solar, el asteroide B 612 difícilmente se contaría entre las áreas prioritarias para establecer una reserva biológica. Efectivamente, si un hipotético exobiólogo realizara el inventario del planetoide hogar del Principito de Saint-Exupery, se encontraría con una flora representada por una vanidosa flor encerrada en un domo protector, unas cuantas flores de otra especie no muy bien determinada y unos cuantos brotes de baobab. Asimismo, encontraría que no existe fauna nativa en el lugar, y que el único animal es un borreguito encerrado en una caja. El asteroide no entraría, definitivamente, en las listas de sitios de megadiversidad.

El término “megadiversidad” fue acuñado hace algunos años por el biólogo estadounidense Russell Mittermeier para definir a la docena de países en los que se concentra la mayor parte de la diversidad biológica del planeta. Para identificar estos países megadiversos, Mittermeier recopiló información sobre el número de especies de los principales grupos biológicos y constató que existen unas pocas naciones que sobresalen en casi todos los rubros. México, por ejemplo, está incluido en este selecto grupo de países porque tanto su flora de plantas vasculares como sus faunas de reptiles, anfibios y mamíferos se encuentran entre las diez más ricas del planeta en número de especies. La riqueza de especies, es decir, el total de especies de plantas o animales que se encuentran en un sitio dado, es un criterio relativamente fácil de medir e interpretar, y en muchos casos se ha usado como sinónimo de biodiversidad. Para muchos biólogos, el conteo de especies se ha convertido en una especie de obsesión por cuantificar de alguna manera un fenómeno tan complejo como lo es la diversidad biológica. Un libro reciente sobre el tema, por ejemplo, define a la biodiversidad como “una biología de números y diferencias”.

El Principito no se preocuparía en lo más mínimo si un exobiólogo exageradamente cuantitativo menospreciara su pequeño asteroide debido a su pobreza de especies. Seguramente tal biólogo le haría recordar al hombre de negocios que vivía en otro asteroide y que había logrado contar quinientos millones seiscientos veintidós mil setecientas treinta y una estrellas y que se pensaba dueño de todas ellas por el simple hecho de haberlas catalogado. Podemos imaginar a un exobiólogo visitando el pequeño planetoide del Principito, observando con desdén a su alrededor y comentando en forma despectiva que en la Tierra existe un número aún no determinado de especies de plantas y de animales, pero que la cifra seguramente rebasa las treinta millones de especies. El Principito, sin inmutarse demasiado, se encogería de hombros y preguntaría: “¿Y qué hacen con todas esas especies?”, para rematar con una de sus frases favoritas: “Los adultos son definitivamente extraordinarios”.

Sin duda, la catalogación de las especies de plantas y animales de cada país es un paso importante para el conocimiento y el adecuado uso de la riqueza biológica. Sin embargo, esa labor debe ir aparejada por una comprensión más profunda de lo que implica el término biodiversidad. Hay que recordar que lo que ahora observamos como diversidad biológica es el resultado de millones de años de evolución orgánica y que las diferentes especies que observamos hoy día no son sino un pálido reflejo de la increíble variedad y variabilidad dentro y entre los organismos vivos. Cierto, el conteo de especies nos sirve de guía para estimar la diversidad de un sitio, pero poco nos dice sobre la variación que existe entre los individuos de cada una de las especies, además no toma en cuenta la diversidad genética contenida en esos organismos, ignora la estructura de las comunidades de plantas y animales y olvida la complejidad de las relaciones funcionales dentro de los ecosistemas.

El caso de México es muy ilustrativo. Sin duda es interesante e importante saber que en nuestro país existen alrededor de veinteséis mil especies de plantas vasculares, cerca de doscientos ochenta de anfibios, más de setecientas de reptiles y aproximadamente cuatrocientos cincuenta de mamíferos terrestres. Tal vez también es relevante conocer que nuestro país cuenta con treinta y cinco especies de esquizómidos, diez ricinuleidos, trecerafidiópteros y nueve mecópteros, pero si nos quedamos únicamente con los números fríos y no vemos más allá del simple conteo, caeríamos en el mismo absurdo que el hombre de negocios que se creía dueño de millones de estrellas y lo único que poseía era un papel en el que anotaba sus compilaciones estelares.

Dentro de cada especie, cada individuo es un reservorio único de información genética que se manifiesta en la variabilidad que presentan todas las especies de plantas y animales. Esta variabilidad se hace evidente a nivel local en las diferencias que existen entre los individuos de una población, y a nivel del país en la variación geográfica de las especies. Por ejemplo, todos los venados de cola blanca del país pertenecen a la misma especie (Odocoileus virginianus), pero no se necesita ser especialista en biodiversidad para percibir diferencias entre los venados de un sitio en particular: habrá algunos que tengan las astas más grandes, otros que sean capaces de saltar más alto, o tal vez una de las hembras que tenga un color más pardo que las otras. A nivel geográfico, las diferencias son aún más marcadas: los venados del norte del país son notablemente más grandes que su contraparte en el sureste del país, a pesar de pertenecer a la misma especie. Estas diferencias entre individuos son un componente importante de la biodiversidad que pasamos por alto al simplemente contar especies para cuantificar la riqueza biológica.

En otros niveles de organización existen otras manifestaciones de la biodiversidad. A nivel de las comunidades ecológicas, la composición de especies y las interacciones entre ellas varían considerablemente de un sitio a otro. Para cualquier persona resulta obvia la diferencia entre un desierto y una selva tropical en cuanto al tipo y número de especies de plantas y animales que se encuentran en estos biomas. Sin embargo, la estructura de esos conjuntos de organismos, por ejemplo en cuanto al número de individuos de cada especie y sus caractérísticas morfológicas, resulta menos evidente. Asimismo, la compleja red de interacciones entre los organismos es aún menos conspicua y sin embargo es una parte importante del fenómeno que llamamos biodiversidad.

El asteroide B 612 podrá ser muy pobre en especies, pero su único habitante puede jactarse de conocer y comprender en forma más profunda la biodiversidad de su hogar que cualquier ser humano del planeta Tierra. A través de sus actividades cotidianas, el Principito efectúa un programa eficiente de conservación y manejo de sus recursos. En efecto, al controlar el crecimiento de las plántulas de baobab, regar su preciada flor y deshollinar los tres volcanes del planetoide para evitar erupciones violentas, el habitante de B 612 usa, pero al mismo tiempo protege, la diversidad de este asteroide. Es más, al hacerlo, el pequeño y misterioso ser ama con pasión y se integra en cuerpo y alma a la riqueza biológica de su planeta, por magra que ésta pueda ser.

Desesperado por la codicia del hombre de negocios al contar estrellas, el Principito le espetó: “Es útil para mis volcanes y es útil para mi flor que yo los posea. Pero tú no eres útil a las estrellas”. Este concepto de posesión de la riqueza biológica a través del servicio mutuo es algo que debería hacernos pensar a la hora de diseñar proyectos de manejo de los recursos naturales. Asimismo, deberíamos ir más allá de los simples números, comprender más profundamente la relevancia y las implicaciones de algo tan complicado como lo es la biodiversidad y tratar de ver las miles de sutiles facetas que oculta el fenómeno de la diversidad de los organismos sobre nuestro planeta. Parafraseando al zorro filósofo que se encontró el Principito en la Tierra: la biodiversidad sólo se ve bien con el corazón. Su parte esencial es invisible para los ojos.

|

||||

|

Lecturas adicionales

Saint-Exupéry, A. 1943. Le Petit Prince. Existen muchas traducciones al español de este clásico que nos puede enseñar mucho sobre la biodiversidad y sobre la vida.

Los datos sobre el número de especies en México fueron obtenidos de: conabio. 1998. La diversidad biológica de México: estudio del país. Comisión Nacional para el Conocimiento y Uso de la Biodiversidad.

|

||||

|

Héctor T. Arita

Instituto de Ecología,

Universidad Nacional Autónoma de México.

_______________________________________________________________ como citar este artículo → Arita, Héctor T. (1999). La biodiversidad en el Asteroide B 612. Ciencias 53, enero-marzo, 40-42. [En línea] |

||||

|

|

||

|

|

|||

|

La creación de la Facultad de Ciencias

|

|||

|

Raúl Domínguez Martínez

conoce más del autor

|

|||

|

|

← Regresar al índice ⁄ artículo siguiente → | ||

|

Es una idea casi unánime que la presencia de México en la vertiente principal de la producción científica y tecnológica a nivel mundial es reconocida como de bajo relieve. De hecho, constituye un lugar bastante común referirse a la inexistencia de una ciencia mexicana (o, mejor dicho, a una ciencia hecha en México, para no ofender a los partidarios de la Ciencia como absoluto), así como a la de una tecnología propia. Desde luego, como todo lugar común, esta afirmación es inexacta y deja de lado una actividad que se ha mantenido vigente aun en contra de obstáculos diversos y de estímulos exiguos y a veces nulos. Trabajos recientes en el campo de la historia de la ciencia están participando en la recuperación de esta faceta del devenir social, que había traspasado los umbrales del olvido al verse cotejada con los momentos estelares de la historia de la ciencia en la civilización occidental, en una comparación de suyo desmesurada.

Los ejemplos abundan respecto de los logros científicos y tecnológicos alcanzados en el país a través del tiempo, aun si nos atenemos a los más conocidos. Ahí está la asombrosa obra de botánica y medicina conocida como Códice Cruz–Badiano, que fue preparada por dos eruditos indígenas en el Colegio de Tlaltelolco para demostrar a Carlos V la capacidad y el nivel de los conocimientos autóctonos en la materia, en muchos sentidos superiores a los europeos de su tiempo; como sabemos, el emperador desestimó esta obra, quedando desde entonces bajo la custodia de la Iglesia en calidad de cosa curiosa. El enorme impulso que recibió la minería a mediados del siglo XVI, se debió al método de amalgamación de la plata con azogue, conocido como “beneficio de patio”, desarrollado en esta tierra por Bartolomé de Medina. La modernización de la astronomía y de la matemática, lograda en el pleno oscuransotismo de raigambre religiosa que prevalecía en la Real y Pontificia Universidad de México durante el siglo XVII, fue merced a las enseñanzas y escritos de un oriundo de nuestros valles centrales llamado fray Diego Rodríguez. La vocación enciclopédica de Alzate y su Diario literario de México así como el caso de otras publicaciones de carácter científico, nos demuestran claramente que la ciencia nunca —menos aún en las sociedades prehispánicas— ha sido algo ajeno a las preocupaciones y prácticas de los mexicanos. Sin embargo, por más minucioso que se haga este recuento de figuras excepcionales, de contribuciones, y aun de periodos en los que se ha configurado una cierta tradición científica, no lograremos encontrar nombres que se pudiesen poner al lado de los grandes artífices de la ciencia occidental. Más aún, no obstante de que contásemos con algún personaje de la talla de Copérnico, Kepler, Curie o Fermi, el problema en realidad se refiere a las condiciones concretas y particulares que han determinado un “subdesarrollo” en materia de ciencia y tecnología, con todas las implicaciones que este término —importado del léxico de la economía política— supone, particularmente, la de dependencia. Es preciso tener en cuenta que el binomio ciencia–tecnología, incluyendo las diferencias históricas y operativas que se puedan reconocer entre estos dos términos, constituye hoy día un factor determinante para definir los niveles reales de desarrollo y de independencia efectiva de una nación. Es decir, una sociedad que en la actualidad no cuente con un aparato sólido y eficaz de producción de ciencia y de tecnología, se encuentra amenazado de una vulnerabilidad extrema que tiende a permear todos los órdenes de la vida colectiva, empezando por el económico. Planteado desde esta perspectiva, el problema adquiere una dimensión distinta y más amplia. La pregunta sería entonces ¿por qué México se ha mantenido a la zaga (lo contrario de la vanguardia) en estos terrenos? Naturalmente, la respuesta es demasiado compleja y me parece que todavía no es posible acceder a ella de manera cabal. Por supuesto, se debe descartar de entrada y en definitiva cualquier recurso explicativo en el que la incapacidad subjetiva juegue algún papel. Semejante precariedad explicativa nos remitiría a la polémica lamentable que sostuvieron algunos destacados pensadores españoles a raíz del descubrimiento de América, como fray Domingo de Betanzos o Pedro Mártir de Anglería, empeñados en dilucidar si los oriundos de estas tierras eran seres humanos o no. La ciencia, así como la tecnología, son efectos de condiciones sociales específicas, en mucho mayor medida que resultado de “genialidades”. El escenario original Al despuntar el presente siglo, la ciencia y la tecnología en México presentaban una panorámica poco alentadora. Los parcos avances que se habían logrado en estos campos, merced a los empeños de los ideólogos porfiristas comprometidos con el prurito cientificista del positivismo, resintieron los estragos de la lucha armada, reduciéndose a una expresión ínfima. La presencia de la tecnología de punta en el país en el contexto del porfiriato no debe incluirse en estas consideraciones, pues hasta los operarios de los equipos eran de nacionalidad extranjera. De hecho, podemos decir que una vez que la Revolución estalló, el de por sí débil aparato de investigación y desarrollo de la ciencia fue desarticulado. Curiosamente, para los efectos del tema que nos ocupa, la única institución porfiriana que habría de sobrevivir a la revuelta sería la Universidad. Como sabemos, esta entidad abrió sus puertas apenas dos meses antes de que, con asombro de puntualidad, la Revolución diese inicio justo en el momento previsto por Madero. Podríamos mencionar, para establecer un contraste paradójico, que el Instituto Tecnológico de Massachusetts (MIT) hizo lo propio el mismo año que dio término la Guerra de secesión en Estados Unidos. Daría la impresión de que la inoportunidad histórica ha marcado nuestros procesos como un sino. El caso es que mientas el vértigo de la violencia iba dando cuenta de lo poco —o mucho, según el parámetro que se quiera emplear— que se había logrado estructurar para fomento de la ciencia, la flamante y amenazada Universidad Nacional se aferraba con hálito vital a la existencia que, gracias a la convicción y a los desempeños de hombres insignes, ha conservado hasta la fecha. Ahí se sostuvo el impulso en favor de la ciencia, pero no logró salir inerme; ya que la Escuela de Altos Estudios, vanguardia indiscutida del desarrollo científico del país y parte constitutiva de la Universidad Nacional por decisión ejecutiva, pasó de ser una institución predominantemente científica a humanística, llegando, en el transcurso de 1912 y a consecuencia de los drásticos recortes presupuestales ¡ojo!, al extremo de verse incapacitada incluso para la contratación de profesores mexicanos regulares, siendo que hasta entonces contaba dentro de su planta con prestigiados académicos extranjeros. Es de suponerse que el costo menor de las indagaciones humanísticas fue lo que marcó la pauta para que lo científico cediera terreno. La nueva orientación de Altos Estudios se perfiló, en lo que a ciencia se refiere, hacia la creación de cursos libres, llamados así porque no dependían ni de financiamiento, ni de matrícula, ni de sistematización formal, ni de nada, como no fuera la vocación y el ánimo inquebrantable de unos cuantos eruditos empeñados en que la sociedad contara con espacios para la actividad científica. Adolfo Castañares, en Química, y Sotero Prieto, en Matemáticas, son dos de los conspicuos personajes que mantuvieron vivo el interés por la ciencia en circunstancias muy poco propicias. Sin embargo, para darnos una idea de lo que esto representaba a nivel nacional, diremos que en esas fechas, Sotero Prieto impartía sus cursos a un total aproximado de veinticinco estudiantes. ¿Qué sentido guardaban estas proporciones en una sociedad que se abría paso en pleno siglo XX? Muy pobre, sin duda, pero superior a nada. Tengamos en cuenta que antes de que se iniciara la Revolución en México ya se había logrado la comunicación telegráfica sin hilos a través del Atlántico; Orville Wright había conseguido el vuelo de un artefacto propulsado, más pesado que el aire y ya habían aparecido los trabajos de Lorentz, Einstein y Minkowski sobre la relatividad restringida. La ciencia y la tecnología se encontraban en auge y su papel en el desarrollo de los pueblos adquiría un relieve cada vez más acusado; lejos quedaban los tiempos en los que el conocimiento científico había suministrado la máquina de vapor a una industria basada casi por entero en las técnicas tradicionales y que debía mucho más al talento de los artesanos que a la ciencia. Ahora, la ciencia asumía un papel protagónico y estrechaba nexos con la tecnología. Si se me permite la expresión, diría que el siglo XX comenzaba para Occidente bajo el signo de tecnologías con una cuota creciente de sofisticación científica incorporada. Era —y sigue siendo— la pauta del progreso. Y la nación mexicana entró al siglo soslayando esta promisoria vertiente. En 1917 se reinició la vida constitucional en México. La turbulencia bélica quedaba atrás y se daba comienzo al proyecto nacional, que, según constatamos a la distancia, no fue tan distinto del porfiriano. La educación fue enarbolada como parte fundamental del proyecto, con un marcado sesgo populista que desde luego hizo de lado la atención a la educación superior. La ciencia no formó —como no forma hasta ahora— parte del proyecto nacional. El aparato educativo fue descentralizado y se transformó en administración municipal, desapareciendo la Secretaría de Instrucción Pública. Se creó, en cambio, el Departamento Universitario y de Bellas Artes con el presupuesto más bajo de todas las dependencias gubernamentales: ese año de 1917, se le asignaron cuatro millones de pesos, frente a los ciento veinte millones que recibió la Secretaría de Guerra. El impacto se resintió aun después de concluida la etapa militar: en 1910, el presupuesto ordinario destinado a educación, todavía bajo la administración de Díaz, representaba 7.0% del total; en 1917 esta relación fue de 1.2% y de 0.8% al año siguiente, debiendo esperar hasta 1922 para que el gasto educativo mejorase su participación relativa, con un 12.9% sobre el total. Lo anterior obedecía claramente a una realidad; de acuerdo con los datos del III Censo General de Población aplicado en 1910, en México había 15 160 000 habitantes, de los cuales poco menos de medio millón se ubicaba en la ciudad capital. La población rural, en comunidades menores de diez mil habitantes, representaba 86.5% del total, y la población analfabeta, con diez años o más, ascendía a 72.3%. Es evidente que el objetivo prioritario, y urgente, era el de dar atención a segmentos muy amplios de la población que carecían de enseñanza básica, subordinando y postergando el fomento a la educación superior y, con ella, al desarrollo científico. De esta manera, México dio comienzo a la fase contemporánea de su historia, con la virtual inexistencia de un aparato científico y tecnológico y con la disponibilidad de fomentar estos campos, reducida a una sola instancia: la Universidad Nacional. El papel estratégico de la universidad Las naciones que han marcado la pauta del progreso científico y tecnológico en el mundo, y de manera particular durante el presente siglo, han contado —piénsese en cualquiera de las que integran el con-junto— con un aparato bien estructurado que se encarga de gestar el desarrollo en tales campos y que, además de ser funcional, se encuentra articulado con otros componentes de la realidad social. Los dispositivos que conforman este aparato son de índole diversa e incluyen universidades, tecnológicos, academias de ciencias, laboratorios, centros de investigación privados y públicos, y algunos otros más específicos. Es evidente que en todos los casos se trata de una responsabilidad compartida y de funciones diferenciadas. En el caso de México, esto no ha sido así. De hecho, la gran mayoría de estas actividades han sido confiadas a una única institución: la Universidad Nacional. Sólo hasta fechas más o menos recientes esta ingente responsabilidad se ha ido descargando y compartiendo con otras instituciones. Podemos decir, sin exageración, que los dos primeros tercios del presente siglo, la así llamada Máxima Casa de Estudios del país, con la honrosa y excepcional colaboración de otras instituciones de mucho menor cobertura como el IPN, ha encarado por su cuenta estos amplísimos cometidos, supliendo el lugar y las funciones de entidades que, por inexistencia (las universidades y tecnológicos que el desarrollo de la sociedad ha reclamado), por ineficiencia (todos los organis mos antecesores del CONACYT) o por insuficiencia, han generado un vacío. Sus aportaciones en el campo de la investigación han sido —sencillamente— imprescindibles. No existe duda alguna de que la mayor parte de lo que en México se ha logrado en materia de ciencia, en un doble sentido cualitativo y cuantitativo, ha tenido su origen en la Universidad Nacional. Las anteriores consideraciones, aparte de ser un justo reconocimiento, sirven para abordar de manera analítica la función de la Universidad en el contexto de la República. Se trata de un papel estratégico que ha rebasado de forma franca los linderos de una institución particular, para ubicarse en una perspectiva mucho más amplia. Los mexicanos estamos de cierto familiarizados con formas cuyos contenidos efectivos no se corresponden con las definiciones nominales. ¿Cómo explicar, por ejemplo, la existencia de una República democrática y federal en donde un sólo partido ha monopolizado el poder por setenta años y todas las decisiones se toman desde el centro? El asunto se refiere en realidad al funcionamiento de determinados mecanismos o dispositivos que operan a manera de subterfugio, con los cuales se ejerce una práctica que es distinta a la que se designa en la definición formal correspondiente. En el caso que nos ocupa, el de la Universidad, este subterfugio ha tenido como eje dos elementos operativos: el concepto de autonomía y la categoría de nacional. De estos dos elementos se ha valido el poder público para realizar una transferencia de responsabilidades, sin la correspondiente transferencia de recursos efectivos y suficientes, lo que le ha permitido desentenderse directamente de tales responsabilidades, a la vez que mantener su imagen como patrocinador. Es decir, hacia ella se fueron canalizado obligaciones que no han sido acompañadas de dotaciones pecuniarias adecuadas, dejando la respuesta a las limitadas posibilidades de la institución y desbordando el ámbito propio de su competencia. En este horizonte, la Universidad se ha visto compelida a la formación de profesionales en ramas descuidadas por otras instituciones en cuanto a la calidad y también a la cantidad; a la creación de planteles de enseñanza y de investigación que el desarrollo o las previsiones de desarrollo reclaman, y que no son atendidas por alguna otra instancia; a la realización de investigaciones “sobre los problemas nacionales,” financiando, formando investigadores, procurando equipos y laboratorios, etcétera, abarcando un espectro en el que potencialmente todo queda incluido; a la formación de la planta académica de otras instituciones; a la colaboración en el trabajo de elaborar planes de estudio en dependencias ajenas; a la impartición de cursos especiales; a la creación de especialidades y posgrados; al otorgamiento de becas; a la difusión del conocimiento; etcétera, etcétera. Así, podemos afirmar que gran parte de lo que en materia de ciencia y de tecnología se ha realizado en el país se le debe a la Universidad Nacional y que ésta ha actuado de conformidad con su propia vocación, su propia inercia y con recursos escatimados que nunca resultaron suficientes y que ha tenido que administrar con malabarismos que muchas veces rayan en lo milagroso. Más adelante veremos cómo en el caso particular de la Facultad de Ciencias, así como en el de algunos institutos como el de Matemáticas o el de Física, su existencia fue resultado de iniciativas que la Universidad Nacional emprendió por cuenta propia y de las cuales no existían —y no lo hubo por bastante tiempo— equivalentes en todo lo largo y ancho del territorio nacional. Antes de cerrar este apartado, sería conveniente añadir una precisión de gran importancia para ubicar correctamente lo que se ha expuesto. Aparte de la enorme negligencia con la que el Estado mexicano actúa cuando se trata de asuntos que no le son rentables políticamente en un plazo inmediato, la cuestión del escaso desarrollo de las ciencias en nuestro país, problema de características crónicas, se relaciona más a profundidad con el desarrollo de las fuerzas productivas. La producción de ciencia y de tecnología propias no se ha presentado históricamente en nuestro país como una necesidad generada por la sociedad, la cual ha satisfecho esos requerimientos por la vía de la importación. Una sociedad atrasada, marcada por la desigualdad, y una economía desequilibrada, marcada por la dependencia, constituyen condiciones de fondo que se reproducen a sí mismas, determinando un rango de factibilidad sumamente restringido para la ciencia generada en el país. La ciencia y, desde luego, el desarrollo tecnológico resultan inversiones rentables a mediano plazo; el problema es el del financiamiento a corto plazo. Tengamos en cuenta que la burguesía doméstica no está “acostumbrada” a invertir en negocios que no le reditúen ganancias inmediatas y seguras. Se trata de una burguesía local marcada asimismo por el atraso, con una jerarquía de intereses en donde los nacionales se subordinan. No ha resultado, pues, un agente viable para el fomento a la ciencia y la tecnología, como se ha constatado en los hechos; la alternativa, en semejantes condiciones, quedó a cargo del Estado, el que, a su vez, se sirvió delegar esa tarea a un reducidícimo grupo de instituciones encabezadas por la UNAM. La autonomía y el aislamiento A pesar de la acusada desconfianza que los gobiernos emanados de la Revolución le profesaban a la Universidad Nacional, ésta logró sobrevivir y aun incrementar su presencia en el marco de la sociedad. Fueron conflictos ya ajenos a su raigambre porfiriana los que produjeron nuevos focos de conflicto entre la Universidad y el poder público. En efecto, después de la Revolución se pueden identificar tres etapas distintas (hoy día parece configurarse la cuarta) en las cuales la Universidad Nacional se ha redefinido en función de la posición que guarda en el esquema de la administración pública: en 1929 se le concedió una autonomía restringida, con la correspondiente promulgación de una Ley Orgánica; en 1933 se le concedió una autonomía total y se suprimió su carácter de nacional, quedando a expensas de un subsidio aleatorio; en 1945, por convenir así a intereses emergentes, el poder público retomó la tutela de la institución, promulgando la Ley Orgánica vigente. Hay que mencionar que no obstante estos drásticos cambios, la Universidad prosiguió atendiendo sus compromisos de manera ininterrumpida. En 1933, la Universidad tenía matriculados a poco más de nueve mil alum-nos en todos sus planteles, incluida la Escuela Nacional Preparatoria, con un crecimiento relativo de su población del orden de 13% respecto de la inscripción de 1929. En el mismo año, se estima que la población total de la República Mexicana era ligeramente superior a los diecisiete millones, lo que significa que la ya desde entonces Máxima Casa de Estudios del país atendía apenas a 0.05 % del total, cifra insignificante en términos absolutos, máxime si se tiene en cuenta que de tal cantidad sólo una porción reducida alcanzaba la titulación. Por otro lado, estos totales acusaban un fuerte desequilibrio en favor de las “carreras liberales”: las escuelas de Jurisprudencia y de Medicina absorbían, ellas solas, a 38.7 % de la matrícula completa de nivel superior. Como se puede inferir con éstos y otros indicadores, el aporte de la Universidad al desarrollo del país en ese tiempo era, por decirlo de alguna manera, irrelevante. Si ésta era la situación con las carreras más populares, se puede uno imaginar lo que ocurría con las ciencias; baste por ahora con decir que las carreras de Biología, Matemáticas o Física se impartían en la Facultad de Filosofía y Letras, y que tenían un perfil por completo diferente al que ahora tienen. Las de Biología, Matemáticas y Física eran carreras que se impartían a la manera de una Escuela Normal Superior, es decir, para preparar profesores en tales disciplinas. A lo anterior habría que añadir que para la nación —o, mejor dicho, para el programa enarbolado por el gobierno federal, que en el caso nuestro sabemos que no es lo mismo— la presencia de una Universidad insumisa venía siendo, además de poco menos que suntuaria, incómoda. Ello quedó demostrado de manera fehaciente con la promulgación de la Ley Orgánica de 1933, cuando le fue concedida la autonomía total, desentendiéndose el poder público de todo tipo de apoyo, incluido el pecuniario; así quedó asentado en el inciso II, apartado b) del artículo 9 de la Ley aprobada por el Congreso de la Unión en el mes de octubre: “Cubiertos los diez millones de pesos (que el gobierno federal entregará a la Institución), la Universidad no recibirá más ayuda económica”. Las palabras del licenciado Narciso Bassols, entonces secretario de Educación Pública, al ser discutida la iniciativa de ley a la que me refiero, corroboran lo dicho: “no se puede decir que la Universidad haya realizado con provecho sus destinos; no se puede decir que la acción educativa haya progresado. La Universidad tiene una enorme, una grave responsabilidad ante la República, y sólo porque la masa de habitantes del país, situada más allá de la ciudad, no puede apreciar y sentir de un modo palpitante e inmediato, no puede conocer las intimidades de las deficiencias universitarias, no se ha producido una poderosa y tremenda reacción de protesta nacional”. La ruptura con el poder público habría de reportarle a la Universidad una situación de fuerte insolvencia. Pero más allá de esta clase de diferencias entre ambos, lo que realmente sitúa en perspectiva correcta el desarrollo de la institución y su papel en el México de la época, es lo que se refiere a la necesidad de la sociedad en general, y de la planta productiva en particular, de los servicios que ésta ofrecía o podía ofrecer. Es preciso tener en cuenta en este aspecto que el México de los años treintas era un país fundamentalmente agrario. En 1930, 80.7% de los mexicanos vivía disperso en localidades menores de diez mil habitantes, es decir, rurales; el sector primario absorbía a 3 626 trabajadores (PEA) sobre un total de 5 151, es decir, a 70.3% . Y si bien la porción mayoritaria del Producto Interno Bruto no tenía su origen en este sector, debido a su baja productividad (cinco veces menor a la productividad del sector industrial, por ejemplo), la producción agropecuaria y minera constituía la base de la actividad exportadora, determinando de tal suerte que el país estuviese convertido en un importador neto de bienes manufacturados. La tasa de analfabetismo rebasaba el 60% de la población con diez años de edad o más, en el seno de una sociedad polarizada en donde los estratos medios eran minoría. Parece claro que la institución universitaria no era, llanamente, una prioridad nacional. Su relevancia a nivel nacional era ínfima, tanto en lo cuantitativo como en lo cualitativo. Por ello, lo que en realidad significó para el poder público la concesión de la autonomía total, fue la posibilidad de desembarazarse de un problema y de desentenderse de un cometido que, en la forma, se debería cumplir. La línea política que adoptó el general Cárdenas al asumir el gobierno de la República en noviembre de 1934, vino a reforzar más esta situación. En el texto de una carta fechada en septiembre de 1935 para dar respuesta a una solicitud del rector procurando el apoyo económico del gobierno, el presidente de la República acusa a la Universidad de haberse colocado “por su propia voluntad, en un plano de indiferencia con respecto al Programa Social de la Revolución”. Poco tiempo más tarde, en 1937, abrió sus puertas el Instituto Politécnico Nacional, concebido y planeado como una alternativa al liberalismo universitario, dotado de mecanismos tales que el Estado aseguraba un amplio radio de control sobre sus procesos. Frente a semejantes condiciones, los desempeños de la institución educativa se vieron amenazados con severidad. Hacia fines de noviembre de 1937, el rector Chico Goerne preparó una detallada exposición de la situación por la que ésta atravesaba, con objeto de procurar fondos federales. En ella señalaba, por ejemplo, que los fondos solicitados para evitar un desgaste más acentuado no representaban ni 1% de los egresos del erario; que los honorarios del profesorado se encontraban a niveles inferiores a los devengados diez años antes, ya de suyos exiguos, encontrándose entre los más bajos del mundo, y que los profesores debían atender normalmente a grupos no menores de cien alumnos y, en muchas ocasiones, superiores a trescientos. En ese tiempo, las reducciones voluntarias de salario se volvieron más o menos frecuentes, las donaciones de equipo constituyeron una alternativa ante la incapacidad de la institución de allegárselo por sí misma, llegando al grado de que en 1940 el Banco de México hubo de donar mil sillas para poder sentar a otros tantos alumnos a recibir sus clases. Las obras de infraestructura quedaron congeladas e, incluso, diversos bienes inmuebles empezaron a evidenciar un fuerte deterioro por falta de mantenimiento. En fin, se trataba de una Universidad con un muy marcado déficit económico, objeto de una cierta animadversión por parte del Gobierno Federal y con una presencia sumamente débil en la sociedad, convulsionada por desordenes internos recurrentes y sujeta a una estructura de gobierno que, sobre la base de la paridad, no facilitaba hacer prevalecer los criterios académicos en la toma de decisiones. El estado y la evolución de la ciencia La Escuela de Altos Estudios fue disuelta en 1925 para dar paso a la creación de la Facultad de Filosofía y Letras. Hasta ese momento, los cursos y las investigaciones relativas a las ciencias habían tendido a la desaparición de una filiación institucional, convertidos en acciones de personas singulares que no estaban —no podían estarlo— sujetas a una normativa, ni a una sistematización, ni a la supervisión colegiada, ni mucho menos a una regulación por concepto de emolumentos, tal y como ocurre ahora o como ocurría ya entonces en universidades de mayor desarrollo fuera del país. Si bien es cierto que por la cuota de entusiasmo que ponían los responsables de estas actividades académicas se logró inculcar interés por la ciencia en algunos jóvenes estudiantes que más tarde se convirtieron en científicos de gran prestigio, incluso internacional —ahí está el caso de Sandoval Vallarta, por ejemplo—, la perspectiva y el nivel en el que se desenvolvían eran considerablemente más bajos. En realidad, se trataba casi en exclusiva de actividades de cultura general y, en el mejor de los casos, de formación de profesores. Es evidente que en esa época no existía en todo el país disponibilidad de empleo para que egresados de matemáticas o de física se desempeñaran como tales. La herencia con la que la institución se acercaba a su vida autónoma era ciertamente pobre. En matemáticas, la Escuela de Altos Estudios había podido ofrecer tan sólo cuatro cursos libres, sin ningún plan de estudios que les diera unidad, a cargo de Sotero Prieto, Juan Mancilla y Río, Luis Espino y Daniel Castañeda. En Física se impartieron únicamente dos cursos entre 1912 y 1914, a cargo de Valentín Gama y Joaquín Gallo. La rama de Química fue más favorecida y en 1916 se fundó la Escuela de Ciencias Químicas, a cargo del ingeniero Salvador Agraz. En Biología se llegó incluso a la impartición de dos carreras: la de profesor en Botánica y la de profesor en Zoología; éstas se fundieron en una sola a partir de 1922. Sin embargo, al ocurrir en 1925 la conversión en la Facultad de Filosofía y Letras no se registró ninguna repercusión en el campo de las ciencias, las cuales prosiguieron con su ritmo habitual. El paso siguiente ocurrió hasta 1928, cuando se reformaron los planes de estudios de las diversas carreras, procurando elevar los objetivos y el nivel académico. La marcha continuaba con paso en exceso lento. No obstante, entonces se gestaba un elemento importante que pronto rendiría frutos positivos, relativo a que ya se había iniciado el envío de estudiantes mexicanos al exterior. En el informe del rector ante el Consejo Universitario, presentado por Ignacio García Téllez, se encuentra una parte en donde dice: “[La Universidad] llama a su seno a los mexicanos que estudian en el extranjero, expuestos a perderse como factores de integración patria, y entre tanto regresan, procura estar en contacto con ellos, enterándolos de nuestra vida y recordándoles su país”. Desde luego, hay que tener en cuenta que estos estudiantes en el extranjero, en particular los de ciencias, tenían ante sí una disyuntiva complicada por obvia: o permanecían en el exterior, o renunciaban a su formación específica, involucrándose en la-bores un tanto ajenas a ella, o se incorporaban a la Universidad como personal académico, ya que ésta era la única instancia en el país con características capaces de asimilarlos en un plano profesional. Ellos habrían de conferirle un sesgo diferente y cualitativamente superior a las ciencias enseñadas e investigadas en la Universidad, la que, por su parte, no cejó jamás de escudriñar y de aprovechar toda circunstancia que le redituara una mejoría.